Искушение вставить на сайт классную, но трагически чужую статью может быть очень сильным. Она круто написана, она полностью раскрывает суть, она лежит в интернете, так зачем множить сущности и писать ещё одну?

Проще скопировать.

Но интернет так не работает. Возразить может как автор оригинальной статьи, так и поисковые роботы.

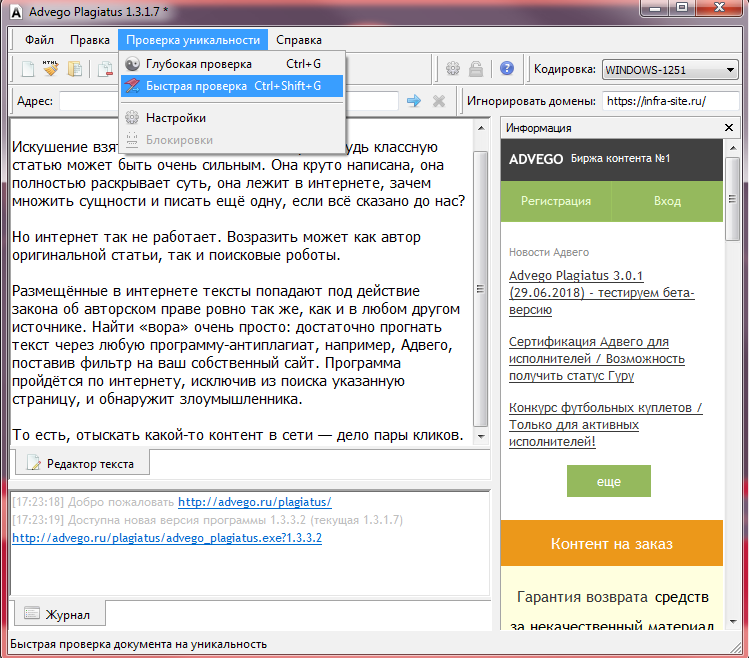

Размещённые в интернете тексты попадают под действие закона об авторском праве ровно так же, как и в любом другом источнике. Найти «вора» просто: достаточно прогнать текст через любую бесплатную программу-антиплагиат, например, Адвего.

То есть, отыскать контент в сети — дело пары кликов.

После чего владелец оригинала может прийти и справедливо поинтересоваться, на каких таких основаниях был скопирован текст.

И если текст вставлялся просто для красоты, это одно дело: он удаляется, вопрос мирно решается с автором оригинала, воцаряется мир и покой. Но если он вставлялся для продвижения, то... скорее всего сайт уже оказался в списке «плохих детей» у поисковых ботов Яндекса и Гугла.

Роботам Яндекса и Гугла не нравится, когда одинаковые тексты распространяются по разным страницам. Чтобы не допустить этого, поисковики используют программы-фильтры, которые могут в лучшем случае занизить позиции сайта в поисковой выдаче, а в худшем — забанить его с концами. Ни один пользователь, ищущий в интернете всякие штуки по ключевым запросам, не увидит забаненный сайт. Роботы бдят.

Фильтры помогают сделать интернет чище, а конкуренцию — честнее. Они не дают пользоваться «чёрными» и «серыми» методами продвижения, например, переспамливать тексты ключевиками, «прятать» контент в коде и... воровать чужие тексты.

Резюмируя: не надо просто брать и копировать тексты из Википедии. Даже если отбросить этику с «нельзя-брать-чужое», поисковые роботы прекрасно понимают, чья статья была опубликована раньше, какая бы дата ни стояла на дубле. Сайт попадёт под санкции, и выбраться из-под них будет ой как непросто.